|

Linux-Arbeitskreis Hamburg |

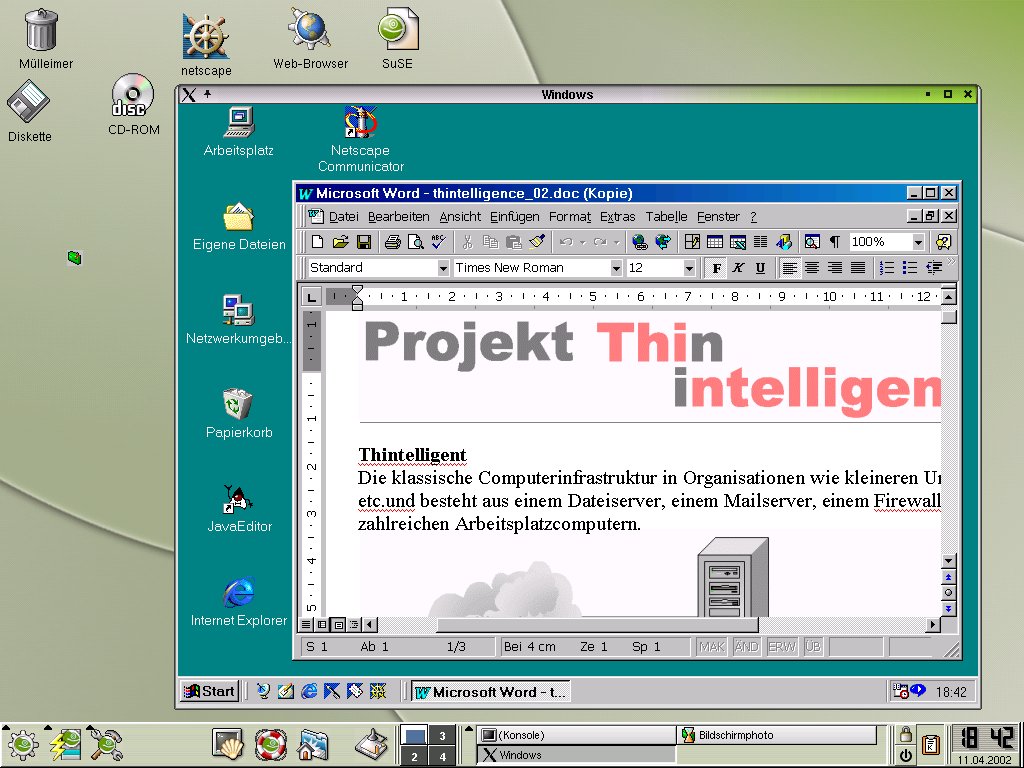

Die klassische Computerinfrastruktur in Organisationen wie kleineren Unternehmen, Schulen etc.und besteht aus einem Dateiserver, einem Mailserver, einem Firewall/Proxyserver und zahlreichen Arbeitsplatzcomputern.

Der Datei-Server stellt in der Regel Dateidienste, der Firewall/Proxyserver kontrolliert die Verbindungen des Intranet ins Internet und der Mailserver bedient die Mailclients. Oft trifft man an den Servern das Betriebssystem Linux an, weil es fast kostenlos ist, kaum Wartungsaufwand verursacht und mit Abstand am wenigsten virengefährdet ist.

Auf den Arbeitsplatzcomputern ist meist ein Windows-Betriebssystem installiert, was einen relativ hohen Pflegeaufwand verursacht, zumal wenn experimentierfreudige oder viele verschieden Benutzer daran arbeiten. Ein besonders hoher Pflegeaufwand entsteht dann, wenn sich Hardware und Betriebssystemversion der einzelnen Arbeitsplatzcomputer auch noch unterscheiden.

Das dezentrale Installieren oder Aktualisieren eines Programmpakets wie MS-Office ist in einem derartigen Netz mit hohem Aufwand verbunden, da die Software an jedem Arbeitplatz einzeln installiert werden muss. Der Aufwand für Office z.B. liegt bei mehr als 30 Minuten pro Arbeitsplatz, bei 20 Arbeitsplätzen macht das dann 10h nur für die Installation eines einzelnen Softwarepakets. Schon mittelgroße Firmen mit mehr als 100 Arbeitsplätzen verfügen zumeist über eine eigene IT-Abteilung. Diese vereinheitlicht möglichst die Hardware- und Software auf allen Arbeitsplätzen, setzt zum Betreuen und Pflegen der Arbeitsplatz-Rechner teure Verteil- und Administrationssoftware ein oder arbeitet mit serverbasierten Systemen auf der Basis von Unix oder Windows Terminal Servern mit Tarantella, Citrix Metaframe oder New Moon. Für kleinere Firmen und Schulen sind diese Wege nicht so geeignet, weil sie weiteres Know-How zum Betrieb dieser Administrations- und Distributionssysteme erfordern und die schlanken Budgets teure, weitere Hardware erfordernde Software nicht einmal im Traum erlauben.

Der serverbasierte Ansatz, die Rechenleistung von den Arbeitsplatzrechnern hin zu zentralen Servern zu schieben, erleichtert die Wartung der Arbeitsplätze aber so erheblich, dass auch kleinere Firmen und Schulen diese Möglichkeiten nutzen sollten. Thin Clients, schlanke Arbeitsplatzcomputer benötigen kaum Pflegeaufwand. Sämtlicher Installations- und Wartungsaufwand fällt nur am zentralen Server an.

Der vorliegende Text beschreibt einen Ansatz, der auch in Organisationen ohne eigene IT-Abteilung möglich ist.

Auf einem zentralen Anwendungs-Server mit hoher Prozessorleistung und einen

sehr guten Speicherausbau wird das Betriebssystem Linux mit der aktuellen

grafischen Oberfläche KDE installiert. Der Server erlaubt eine grafische

Anmeldung für Rechner aus dem lokalen Netz.

Auf den

vorhandenen Arbeitsplatzrechnern wird ein minimales Linux-System mit

Grafik-System installiert oder lediglich eine einheitliche Netzwerkkarte

mit Bootprom und eine einheitliche Bildschirmkarte. Die Rechner melden sich

nach dem Booten und Starten des grafischen Systems am Linux-Server an, alle

weiteren Programme laufen dann auf dem Server. Bei Neubeschaffungen werden

keine Arbeitsplatzcomputer mehr angeschafft, sondern Thin-Clients, die eine

Anmeldung am Linux-Server erlauben (XDM). Sowohl die Computer, als auch die

Thin-Clients arbeiten damit nur als X-Terminals, welche die Tastatur und

Mauseingaben an Software auf dem Server weitergeben, von dort die

Änderungen des Bildschirm-Inhaltes beziehen und auf dem lokalen Bildschirm

darstellen.

Auf den

vorhandenen Arbeitsplatzrechnern wird ein minimales Linux-System mit

Grafik-System installiert oder lediglich eine einheitliche Netzwerkkarte

mit Bootprom und eine einheitliche Bildschirmkarte. Die Rechner melden sich

nach dem Booten und Starten des grafischen Systems am Linux-Server an, alle

weiteren Programme laufen dann auf dem Server. Bei Neubeschaffungen werden

keine Arbeitsplatzcomputer mehr angeschafft, sondern Thin-Clients, die eine

Anmeldung am Linux-Server erlauben (XDM). Sowohl die Computer, als auch die

Thin-Clients arbeiten damit nur als X-Terminals, welche die Tastatur und

Mauseingaben an Software auf dem Server weitergeben, von dort die

Änderungen des Bildschirm-Inhaltes beziehen und auf dem lokalen Bildschirm

darstellen.

Reine Linux-Arbeitsplätze sind wegen des aggressiven und erfolgreichen Marketing von Microsoft zur Zeit kaum durchsetzbar, obwohl die Softwareauswahl für Linux-Plattformen immer besser und umfangreicher wird. Schon lange bieten Windows-Emulatoren unter Linux eine Laufumgebung für Windows-Anwendungen. Die bisherigen Emulatoren konnten aber meist nicht mehrfach gestartet werden. Wenn 20 Terminals gleichzeitig mit Windows-Programmen arbeiten wollen, dann muss man den Emulator entsprechend oft starten können. Das Produkt NSSE der Firma NeTraverse ermöglicht genau dieses. Es erlaubt, auf einem Linux-Server mehrfach Windows 9.x und Windows-Anwendungen zu installieren Damit stehen an jedem Terminal-Arbeitsplatz sowohl Linux- als auch Windows-Programme zur Verfügung.

Das Nutzen eines Windows-Emulators bietet den großen Vorteil, dass alle virtuellen Windows-Computer über identische Hardware verfügen. Software braucht man nur einmal zu installieren, danach kann man für die weiteren Arbeitsplätze einfach die Referenzinstallation kopieren, was pro Arbeitsplatz 2 bis 5 Minuten beansprucht.

Damit können sämtliche Windows-Arbeitsplätze jede Nacht automatisch neu installiert werden.

Die Anforderungen an die Server-Hardware sind hoch, wenn die Anwendungen auf dem Server laufen sollen. Gerechnet jeweils auf 20 Client-Zugriffe.

Die Anforderungen an die Clients sind gering. Entweder nimmt man aktuelle Thin-Clients oder alte PC-Systeme mit:

Zur Zeit sind leise, festplattenlose Client-Geräte für knapp 300 € zu bekommen. Diese Geräte sind fast zu schade, um sie als dumme Clients an einem Applikationsserver zu betreiben. Bei derartigen Geräten macht es Sinn sie zwar vom Anwendungsserver zu booten, die Anwendungen aber lokal auszuführen. Das entlastet den Applikationsserver erheblich!

Ein solche Gerät verfügt über folgende Ausstattung

Die Geräte sollten nur über eine PXE-fähige Netzwerkkarte verfügen, damit sie problemlos vom Server booten können. Die Erweiterung der Software-Konfiguration auf dem Linux-Server beschreibt der Text über Linux Diskless Clients.

Die Kosten für die verschiedenen Ansätze im Vergleich zum klassischen Ansatz.

Kalkulation für ein System mit 20 Arbeitsplätzen:

| Klassische Infrastruktur | Thin Clients (z.B. Igel) | Thin Client (Altgeräte) | LDC Clients | |

|---|---|---|---|---|

Server |

2.500 € | 5.000 € | 5.000 € | 3.000 € |

| Client incl. Tastatur/Maus | 14.000 € | 9.000 € | 2.000 € | 6.000 € |

| NSSE (Windowsemulator) | - | 2.300 € | 2.300 € | 2.300 € |

| Windows 9.x | 2.000 € | 2.000 € | 2.000 € | 2.000 € |

| Linux-Distribution | 80 € | 80 € | 80 € | 80 € |

Summe |

18.580 € | 18.380 € | 11.380 € | 13.380 € |

Am preiswertesten ist natürlich die Arbeit mit Altgeräten, zumindest was die Hardware-Kosten betrifft. Der Abstand zu den Diskless-Clients ist aber nicht besonders groß. Deutlich größer ist der Preisunterschied zum klassischen Ansatz bzw. den Industrie Thin-Clients.

Das System ist leicht skalierbar, sollten mehr als 20 Arbeitsplätze benötigt werden, so wird ein zweiter Server installiert.

Einmal installiert macht das Thintelligent.net kaum mehrAufwand als ein einfacher Server, da sämtliche Software auf dem Server liegt. Der gesamte Arbeitsaufwand an den Arbeitsplätzen entfällt ersatzlos.

Dabei darf nicht vergessen werden, dass die Gesamtkosten für einen Computerarbeitsplatz (TCO) normalerweise nur zu 20% aus den Anschaffungskosten bestehen. Den größten Teil der Kosten machen Wartung und Betreuung aus.

Im schulischen Bereich werden die übrigen 80% der Gesamtkosten normalerweise

vollkommen ignoriert. Dabei kommt gerade hinzu, dass in Schulen die Geräte

relativ alt sind und von sehr vielen Nutzern abwechselnd bedient werden.

Die Forderung nach mehr Betreuung für die Schulen bzw. mehr Entlastung

für die betreuenden Lehrer läuft angesichts der Haushaltslage und

der Größenordnung der Kosten ins Leere.

Dem Gymnasium Lohbrügge z.B stehen aus dem Projekt "Lernen mit Neuen

Medien" etwa 15.000 € pro Jahr für Beschaffung von Hard und Software

zur Verfügung. Dazu müßten dann noch 60.000 € für

die restlichen Bereiche kommen, wirklich zur Verfügung stehen an Entlastung

und Wartungsmitteln etwa 9.000 €.

Alle Terminalserver-Lösungen sind prinzipiell geeignet hier zu deutlichen Arbeits-Entlastungen zu führen und den Computer-Einsatz in Schulen überhaupt erst sinnvoll zu machen.

Wir haben bisher kaum Windows-Software gefunden, die mit dem hier beschriebenen System nicht läuft. Lediglich Programme, die direkt auf die Hardware zugreifen oder DirectX benötigen laufen zu Zeit nicht. Falls man das unbedingt auf Windows haben will, müsste man eine (kleine) Zahl proprietärer Windows-Arbeitsplätze vorhalten.